昨天介紹過VCDNet今天來說一下關於ImageNet舉辦LlSVRC所產生的CNN模型。

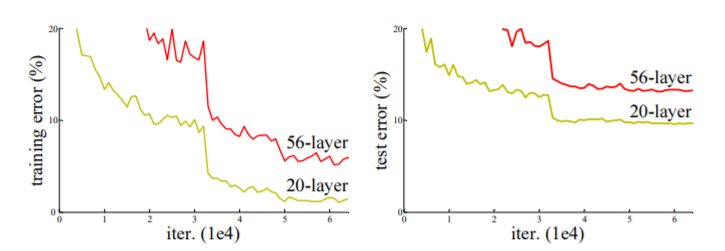

昨天我們講VCG的時候是說深度學習越深越好,但如果一直無限的增加層數,結果是不是比較好呢,直到我看到這個論文,才發現夷!!!怎麼56層網路比20層的還差,不是越深越好嗎?

參考https://arxiv.org/pdf/1512.03385.pdf

當今天層數越疊越深,若不做任何的處理機制,準確度其實是會越來越糟糕!因為當疊層數疊超過一個層數,反向傳遞的梯度要越來越多次才能到最前面的參數,所以把層數加深就很有可能造成梯度消失,就會無法有效的更新前面網路層的參數。因此Deep Residual Network就出現了,也就是ResNet

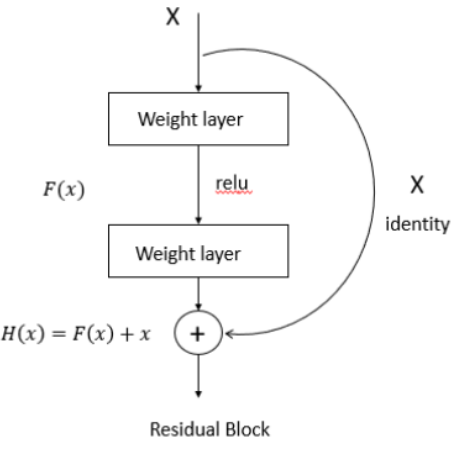

DRN就是使用反向傳遞,當學習到比較飽和的準確度的時候,我們將x輸入近似於H(x),這樣就能保持後面的層數不會引響準確度下降,輸出的部分加了一個X,目標就是要將F(x)=H(x)-x讓F(x)趨近於0,這樣即使網路加深也不會引響準確度。

https://medium.com/%E9%9B%9E%E9%9B%9E%E8%88%87%E5%85%94%E5%85%94%E7%9A%84%E5%B7%A5%E7%A8%8B%E4%B8%96%E7%95%8C/%E6%A9%9F%E5%99%A8%E5%AD%B8%E7%BF%92-ml-note-cnn%E6%BC%94%E5%8C%96%E5%8F%B2-alexnet-vgg-inception-resnet-keras-coding-668f74879306

https://ithelp.ithome.com.tw/articles/10223034